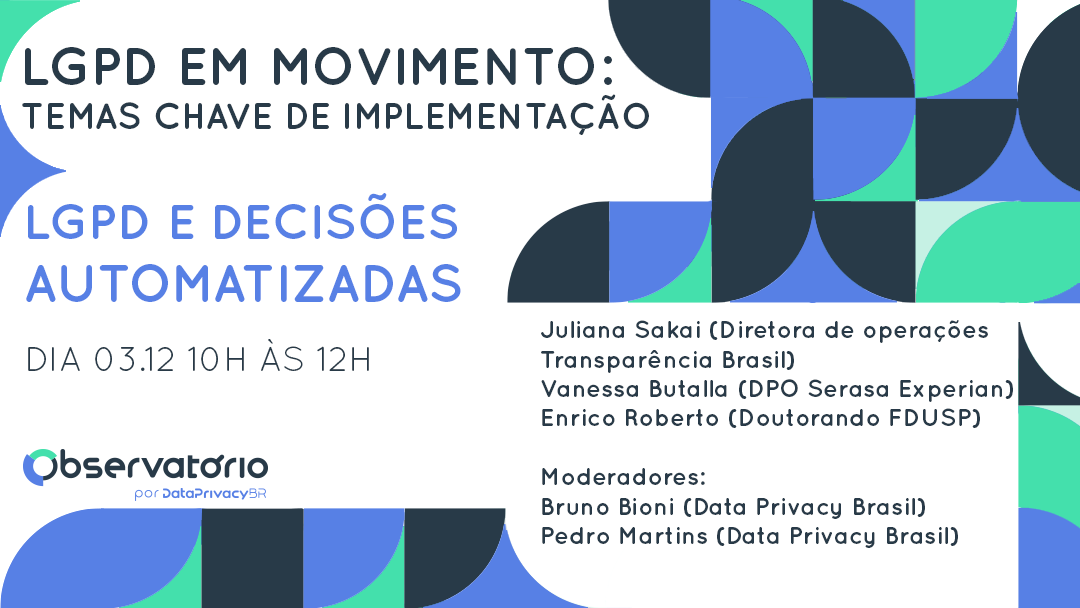

Série LGPD em Movimento: LGPD e Decisões Automatizadas

Dando continuidade à tarefa de endereçar temas sensíveis, ou mesmo polêmicos, da Lei Geral de Proteção de Dados, a Associação Data Privacy Brasil de Pesquisa organizou, no dia 3 de […]

Dando continuidade à tarefa de endereçar temas sensíveis, ou mesmo polêmicos, da Lei Geral de Proteção de Dados, a Associação Data Privacy Brasil de Pesquisa organizou, no dia 3 de dezembro, o quarto Webinar da série ‘’LGPD em movimento: temas chave de implementação’’, que abordou a regulamentação de decisões automatizadas na LGPD.

O que são decisões automatizadas?

Antes de entrar em um debate sobre como a LGPD regulamenta decisões automatizadas, é preciso entender esse conceito. Como Enrico Roberto, pesquisador do Internetlab e doutorando na USP, pontuou, esse conceito ainda está em formação e não há na LGPD uma definição clara para ele, como existem para outros termos que circundam a proteção de dados. Contudo, a lei trouxe em seu artigo 20 alguns direitos que incidem nas atividades de tratamento automatizadas.

Ainda, Enrico pontua que a regulamentação de decisões automatizadas é uma forma que tanto a LGPD, quanto a GDPR, encontraram para fazer referência e incidir sobre uma maneira de tratamento de dados, que é a inteligência artificial.

Podemos então entender decisões automatizadas como processamento de dados feitos por técnicas de inteligência artificial que visam encontrar correlações em um banco de dados e fazer previsões com base nessas correlações encontradas.

Contudo, há um elemento adicional trazido pela LGPD, que é a noção de decisão tomada unicamente com base em tratamento automatizado, visto que o artigo 20 impõe essa condicionante ao direito de revisão.

A confusa ideia de decisão tomada unicamente com base em tratamento automatizado

Como pontuou Enrico Roberto, há sempre uma interação entre os algoritmos e sistemas de inteligência artificial de tomada de decisão automatizada e pessoas humanas. Sendo assim, uma questão que precisa ser melhor analisada é em que momento se pode dizer que uma decisão foi de fato tomada com base unicamente em tratamento automatizado, ou se houve participação humana significativa nesse processo. Em poucas palavras, será adotada uma interpretação: a) literal do termo “unicamente” e que praticamente esvaziará o direito de revisão ou; b) uma outra que desengatilhará tal direito levando em consideração o grau de automatização desses processos decisórios, ainda que este não sejam totalmente automatizados?

Juliana Sakai, diretora de operações do Transparência Brasil, contou que o projeto Transparência Algorítmica está realizando um mapeamento no Governo Federal para entender como o Poder Público está fazendo uso de algoritmos de tomada de decisão automatizada. Dentro desse mapeamento, nenhum órgão afirmou que essas ferramentas tomam ações, e todas seriam usadas apenas para dar suporte à tomada de decisão humana.

Fica então evidente a tensão entre o conceito de decisão unicamente automatizada e a prática corrente de uso dessas ferramentas. Enrico propõe, nesse sentido, a compreensão de uma decisão totalmente automatizada como aquela em que todas as fontes de informação necessária para se chegar à decisão vieram do algoritmo, e não daquela pessoa apontada como responsável para tomar a decisão.

Assim, a inserção de um humano no processo de tomada de decisão (human-in-the-loop) só descaracterizaria a noção de “unicamente automatizado” caso ela de fato tenha competência e uma atuação significativa no processo de tomada de decisão. A mera validação da decisão por um humano, um papel meramente formal, não descaracterizaria a decisão totalmente automatizada.

Os direitos previstos pelo art. 20 e o direito de revisão

O direito de revisão de decisões automatizadas, previsto pelo art. 20 da LGPD, já existia dentro do microssistema do setor de crédito na Lei do Cadastro Positivo (Lei 12.414/11). Segundo Vanessa Butala, do Serasa Experian, no momento da elaboração da Lei do Cadastro Positivo a preocupação desse direito de revisão se dava sobre a decisão final, de concessão ou não de crédito. A LGPD, segundo Vanessa, deu um passo adiante nesse tema, não se atendo somente à decisão final, mas também incidindo nos processos de formação de perfis, garantindo um maior dever de transparência no caminho que leva à decisão final.

Contudo, no processo de aprovação da LGPD houve o veto parcial ao trecho do artigo 20 que determinava o direito de revisão como um direito de revisão humana, ou seja, feito por uma pessoa natural. Segundo Enrico Roberto, esse veto trouxe uma insegurança jurídica ainda maior, removendo a clareza de qual tipo de revisão deve ser feito, além de remover a “unha” do artigo, ou seja, deixá-lo mais fraco.

Quanto à operacionalização do direito de revisão dentro do escopo de score de crédito, Vanessa Butala entende que o titular tem direito de acesso às informações que foram consideradas para se chegar à pontuação de crédito. Isso daria um controle, para o titular, de corrigir ou atualizar alguma informação e a partir dessa correção uma nova pontuação pode ser alcançada. Por outro lado, em relação à fórmula e aos pesos atribuídos a cada elemento para a chegada no score final, haveria nesse caso a proteção dessas informações com base no segredo de negócio.

Enrico pontuou, ainda, que o art 20 §1º traz um direito às informações relevantes para a decisão automatizada, e propôs uma interpretação de que devem ser fornecidas as informações necessárias para o exercício dos demais direitos dos titulares, já que ele está previsto no capítulo dos direitos dos titulares.

Transparência

A transparência é um dos temas mais debatidos quando se fala em tomada de decisões automatizadas e uso de algoritmos. Visto que muitas vezes são empregadas técnicas de processamento de dados complexas, como machine learning, a compreensão de como se deu esse processamento e porquê determinado resultado foi alcançado se torna um obstáculo. Contudo, existem outros pontos relativos a esse dever geral de transparência que podem ser melhor explorados e com uma barreira técnica menor.

Juliana Sakai pontua inicialmente que uma maior transparência do poder público em relação ao uso de algoritmos e tomada de decisão automatizada é importante até mesmo para se avaliar a eficiência dessas ferramentas. Mesmo que não exista ameaças a direitos fundamentais, deve-se avaliar como elas estão sendo usadas e se há um ganho, de fato, na sua utilização. Além disso, o controle social deve também incidir de forma mais acentuada para decisões mais sensíveis, que podem levar a discriminações, especialmente quando se fala em Poder Público, em que o dever de transparência é ainda mais forte que para o setor privado, não havendo também a incidência do segredo de negócio.

Enrico Roberto pontuou que existem diversos mecanismos para averiguar se decisões automatizadas estão sendo justas e respeitando os princípios da lei sem a quebra do segredo de negócio. Dentre eles, informações como os tipos de dados que são usados para alimentar a base de dados, quais decisões de fato são tomadas por algoritmos, como elas podem afetar direitos fundamentais, quais populações afetadas pela decisão automatizada, bem como informar quais testes foram feitos com aquele algoritmo para evitar discriminações.

Bruno Bioni, enquanto um dos indutores do debate, trouxe também a discussão sobre a elaboração de relatórios de impacto à proteção de dados como um instrumento de intermédio entre o controle social de decisões automatizadas e as medidas de mitigação que eventualmente são (ou não) adotadas pelos controladores. Além disso, há um importante debate sobre a publicação desses relatórios, como forma de ampliar a transparência. No mesmo sentido, Enrico reforçou a importância dessa publicação destes relatórios, ainda que adaptados para não serem divulgados segredos de negócio.

Vanessa afirmou ainda que esse aumento na transparência e na comunicação é um movimento que já se iniciou no mercado de birôs de crédito, aumentando o acesso, aos titulares, às informações que compõem os modelos e se elas impactam positiva ou negativamente o score. Esse movimento teve como pontapé inicial a Lei do Cadastro Positivo, em seguida, outro marco importante foi o Recurso Especial 1.419.697/RS, em que houve a primeira audiência pública da história do STJ para tratar justamente sobre a elaboração de scores de crédito. Em 2014, o Superior Tribunal de Justiça acabou por reforçar o direito à revisão, indiretamente, ao aplicar direitos básicos do Código de Defesa do Consumidor, dentre eles o dever de informação e transparência, ao decidir pela legalidade do credit scoring. O STJ considerou também os princípios da necessidade e da não-discriminação para limitar os dados que poderiam ser usados para essa finalidade:

“Não podem ser valoradas pelo fornecedor do serviço de “credit scoring” informações sensíveis, como as relativas à cor, à opção sexual ou à orientação religiosa do consumidor avaliado, ou excessivas, como as referentes a gostos pessoais, clube de futebol de que é torcedor etc.”

Esse movimento ganha agora um novo capítulo com a LGPD, que vem como marco importante para ampliar ainda mais esse dever de transparência para além da decisão final.

Podemos perceber, a partir do debate como a LGPD trouxe importantes avanços no tema, ampliando o dever de transparência e de fornecimento de informações quanto a decisões automatizadas. Contudo, dois principais pontos ainda aguardam uma melhor definição: i) o que de fato são decisões tomadas unicamente com base em tratamento automatizado, e ii) quais os parâmetros do direito de revisão, já que não há mais a previsão expressa da revisão humana na LGPD.

Por Bruno Bioni e Pedro Martins